IBM ja Google näevad end hästi teel, et aastakümne lõpuks luua täielikult skaleeritud kvantarvutid.

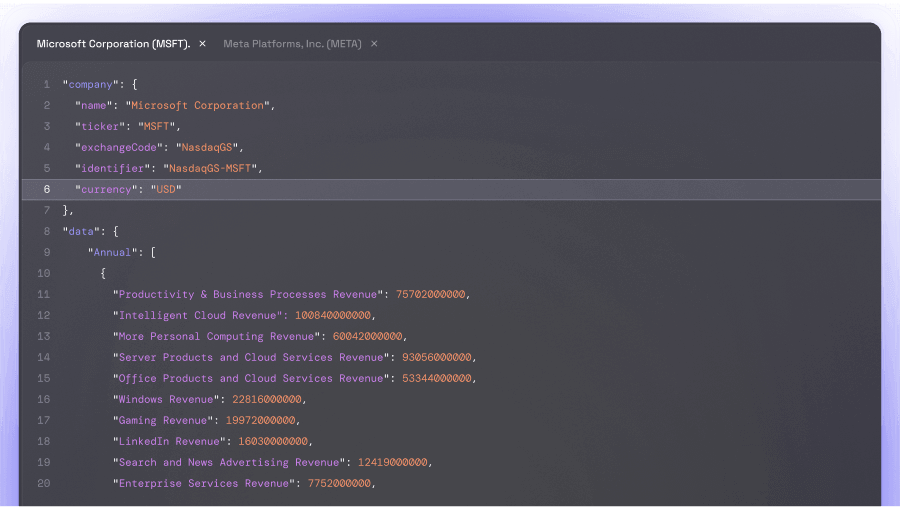

IBM tutvustas juunis ümberkujundatud arhitektuuri-juhtplaani, mis kasutab uut sidetehnoloogiat kvantbittide vaheliste häirete vähendamiseks - probleem, mis ilmnes 433-kvantbitilises kiibis "Condor". Ettevõte järgib veaparanduse protsessis vähese tihedusega pariteedikontrolli lähenemist, mis nõuab 90% vähem kvantbitte kui Google'i "pindkood". Google on seni ainus, kes on näidanud, et tema meetod toimib skaleerimisel, kuid peab IBM-i lähenemist tehniliselt riskantsemaks.

Skaleerimine ei nõua ainult stabiilseid kubitte, vaid ka radikaalset keerukuse vähendamist. Iga komponendi eraldi häälestamine pole suurtes süsteemides praktiline, mistõttu arendavad tootjad vastupidavamaid osi ja tõhusamaid tootmisprotsesse. Google soovib vähendada masina maksumust umbes 1 miljardi USA dollarini, muuhulgas suurendades komponentide kuluefektiivsust kümme korda.

Doch ka füüsika kõrval jääb pingutus tohutuks: süsteeme tuleb käitada äärmiselt sügavkülmutatud erikülmikutes, jagada neid modulaarsetele kiipidele ja realiseerida väiksema juhtmestikuga. Konkurentsitehnoloogiad nagu ioonilõksud või footonkubid pakuvad küll stabiilsuseeliseid, kuid võitlevad väiksema arvutuskiiruse ja keerulisema võrguühendusega.

Marktoloogiaekspertidele, nagu Gartneri analüütik Mark Horvath, on selge: IBM-i viimased kavandid võivad toimida, kuid hetkel eksisteerivad need vaid paberil. Milline tehnoloogia läbi lööb, sõltub tõenäoliselt ka riiklikust toetusest – näiteks DARPA kaudu, mis juba uurib, millised pakkujad suudavad kõige kiiremini praktilisusele vastavaks skaleerida.